Raspberry Pi5でローカルLLMを動作させてみた。どれくらい時間がかかるか試したかったのでネットで多数出てくるインストール方法を検索しつつコマンドを拾いながら設定。

(環境:Raspberry Pi 5 8gb/1TB ssd boot /ubuntu server 24.04.1 LTS/Docker)

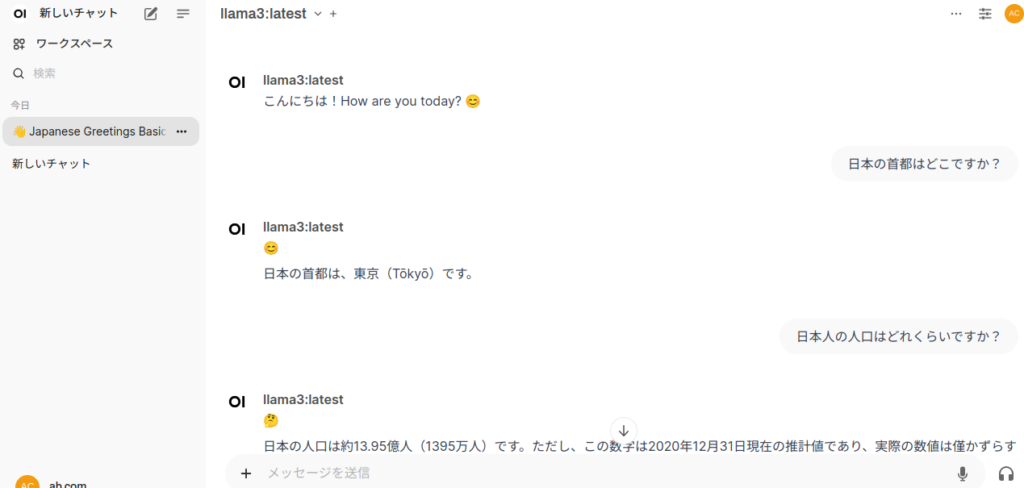

手順としては docker でOllama(オープンソースのAIツール) をインストール後、Chromeを使用して端末からローカルアドレスでアクセスする。(192.168.xxx.xxx:3000)

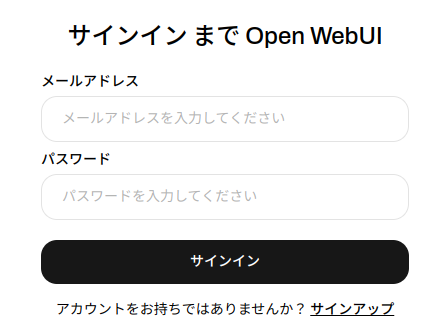

サインイン画面が出るのでアカウントを適当に作成してサインアップ。

ChatGPTのように普通に受け答えが来るが、時間が非常にかかるのがわかる。

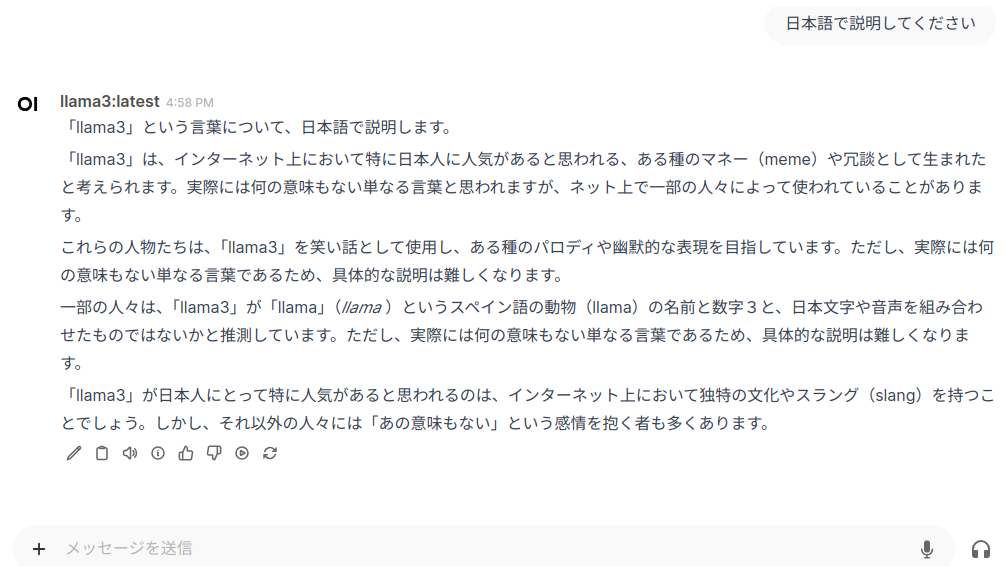

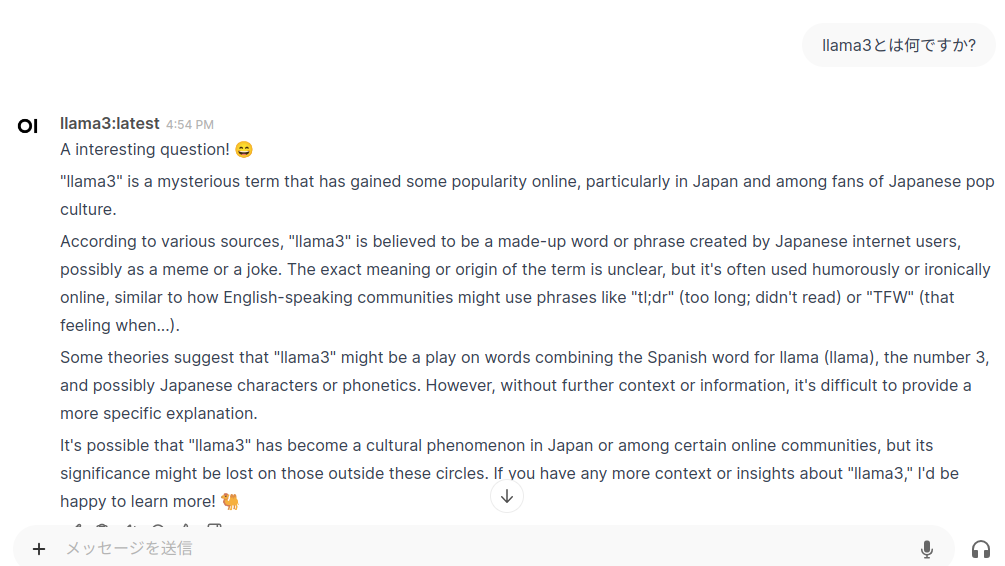

「llama3」とは何ですか?の質問が英語で返されたので日本語での再説明を要求したら、回答までに約5分かかった上に内容も的はずれだった(chatgptは即答)。その後、何度か質問内容を変えて行くとまともな回答がやっと帰って来たという感じだった。